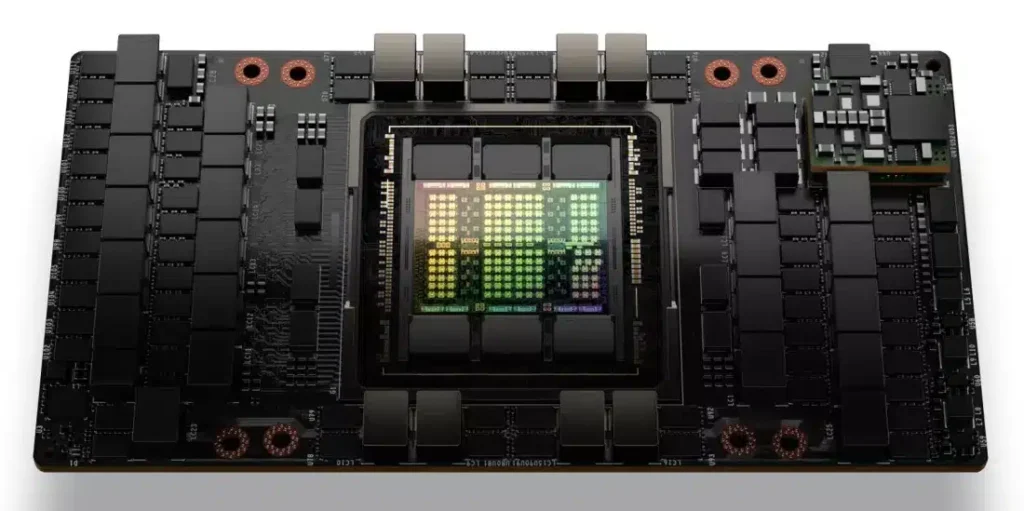

Süni intellekt sürətləndiriciləri ən uğurlu bizneslərindən birinə çevrilməklə milyonlar qazandırmağa davam edir. Belə ki, bu istiqamətdə də NVIDIA H100 süni intellekt sürətləndiricisi ilə bazarın əhəmiyyətli bir hissəsini tutmaq üçün mükəmməl mövqedədir.

Satılan hər NVIDIA H100 süni intellekt qrafik sürətləndiricisi üçün şirkət istehsal xərclərinin 1000%-ə qədər mənfəət marjası bildirərək əhəmiyyətli gəlir əldə edir. Barron’s-da baş texnologiya yazarı Tae Kim qeyd edir ki, Nvidia bir H100 istehsal etmək üçün təxminən 3,320 dollar xərcləyir və bu məhsul son müştərilərə 25.000-30.000 dollar arasında dəyişən qiymətə satılır. Bu təxminlər Raymond James konsaltinq firması tərəfindən də verilmişdir və görünür, HBM yaddaş çipləri ilə bağlı xərclər də bura daxildir.

Hesablamalar düzgündürsə yaşanan hal NVIDIA üçün görünməmiş qızıl dövrün başlanğıcı ola bilər. Üstəlik bu qiymətlərə baxmayaraq AI şirkətləri süni intellektə əsaslanan model və xidmətlərini gücləndirmək üçün kifayət qədər sürətləndirici tapmaqda çətinlik çəkirlər. Foxconn, süni intellekt server bazarının 2027-ci ilə qədər 150 milyard dollar dəyərə çatacağını proqnozlaşdırır. Məhz bu qabaqcıl “AI serverləri” də NVIDIA-nın ən son texnologiyalarının hesablama imkanlarından yararlanır. NVIDIA H100 ən son nəsil GeForce RTX oyun qrafik kartlarını dəstəkləyən Ada Lovelace arxitekturasının analoqu olan Hopper mikroarxitekturasına əsaslanır. H100 sürətləndiricisi 5 ədəd 120 bitlik yaddaş girişinə malik 80 GB HBM3 RAM-a əlavə olaraq 14.592 CUDA nüvəsi olan GH100 GPU ilə təchiz edilmişdir.

H100-ün inkişafı, şübhəsiz ki, çoxlu aparat mühəndisləri və ixtisaslı işçiləri cəlb edən bahalı və vaxt aparan bir iş olmuşdur. Son hesablamalar Nvidia-da bir aparat mühəndisinin orta əmək haqqının ildə təxminən 202.000 dollar olduğunu göstərir. Bütün bunları nəzərə aldıqda müştərilər arasında rəqabətin də böyük olduğu bu bazarda qiymətlərin 10 dəfəyə qədər artması bəlkə də çox təəccüblü olmamalıdır.