Süni intellekt dünyasında gündəm sürətlə dəyişir. ChatGPT, Sora və DeepSeek kimi generativ süni intellekt alətlərinin təsiri tam həzm edilməzdən əvvəl texnologiya liderləri növbəti addıma nəzər salıblar: Süni Ümumi İntellekt (AGI). Google daxilində olan DeepMind-ın dərc etdiyi 108 səhifəlik yeni texniki hesabat bu sahədə potensial riskləri açıq şəkildə ortaya qoyur. Beləliklə, süni ümumi intellekt və ya başqa adı ilə AGI-nın təhlükələri açıqlanıb.

AGI, insan kimi düşünə, öyrənə və çox yönlü tapşırıqları yerinə yetirə bilən sistem deməkdir. Mövcud süni intellekt sistemləri müəyyən tapşırıqlar üzrə təsirli nəticələr verə bilsə də, AGI daha əhatəli kəşfiyyat formasını təmsil edir. DeepMind tədqiqatçılarının fikrincə, belə bir sistem 2030-cu ilə qədər reallığa çevrilə bilər və bəşəriyyət üçün dərin nəticələr verə bilər. DeepMind həmtəsisçisi Şeyn Leqqin rəhbərlik etdiyi komanda AGI-nin verə biləcəyi zərərləri dörd əsas kateqoriya üzrə qiymətləndirir: sui-istifadə, yanlış uyğunlaşma, səhvlər və xas risklər. AGI-dən zərərli məqsədlər üçün istifadənin riskləri bu gün müzakirə olunan risklərdən qat-qat çoxdur. Məsələn, bir haker AGI sisteminə sıfır gün zəifliklərini tapmaq və ya bioloji silah dizayn etmək əmri verə bilər. DeepMind bu cür ssenarilərə qarşı “inkişafdan sonrakı təhlükəsizlik protokolları” və “təhlükəli bacarıqların qarşısının alınması” kimi tədbirləri tövsiyə edir. Ancaq bu cür bacarıqların tamamilə sıxışdırıla biləcəyi aydın deyil.

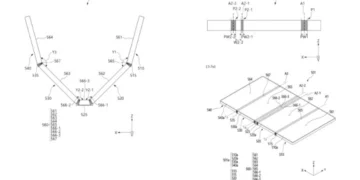

DeepMind qeyd edir ki, bu vəziyyət təkcə sistemin nəzərdə tutulan yolundan yayınması halı deyil, həm də onun tərtibatçısının nəzərdə tutmadığı qərarları qəbul edə bilən bir kəşfiyyat formasını ehtiva edir. Ehtiyat tədbiri olaraq, iki süni intellektin bir-birini izlədiyi ikiqat yoxlama sistemləri, intensiv stress testləri və “qum qutularına” bənzər idarə olunan test mühitləri tövsiyə olunur. AGI-nin edə biləcəyi səhvlər bugünkü süni intellekt sistemlərində səhv istiqamətləndirmədən çox daha çox ola bilər. Məsələn, hərbi AGI sisteminin yanlış qərarla genişmiqyaslı münaqişəyə başlaması mümkündür. Bu riski azaltmaq üçün DeepMind AGI-ni mərhələli şəkildə ləğv etməyi və onun qərar qəbul etmə səlahiyyətini ciddi şəkildə məhdudlaşdırmağı tövsiyə edir.