Süni intellekt çatbotlarından qısa cavablar vermələri istənildikdə, onlar yalan məlumat verməyə meyllidirlər. Paris mərkəzli AI sınaq şirkəti Giskard tərəfindən aparılan yeni bir araşdırma, bunun modelin dəqiqliyinə ciddi təsir göstərə biləcəyini ortaya çıxarıb.

Giskard-ın bloq yazısına görə, suallara qısa cavablar, xüsusən də qeyri-müəyyən və ya mübahisəli mövzular haqqında olanlar süni intellekt modellərinin daha çox “halüsinasiyalar” – saxta, uydurma məlumatlar yaratmasına səbəb olur. Şirkətin tədqiqatçıları bildirir ki, “Məlumatlarımız göstərir ki, sistem təlimatlarına edilən sadə dəyişikliklər modelin halüsinasiyaya meylinə əhəmiyyətli dərəcədə təsir göstərə bilər”. Halüsinasiyalar AI-də həlli çətin bir problemdir. Hətta ən bacarıqlı modellər belə bəzən şeylər uydururlar, bu onların ehtimal xarakterinin bir xüsusiyyətidir. Bundan əlavə, OpenAI-nin o3 kimi yeni mülahizə modelləri əvvəlki modellərə nisbətən daha çox halüsinasiyalar yaradır və onların çıxışlarına etibar etməyi çətinləşdirir.

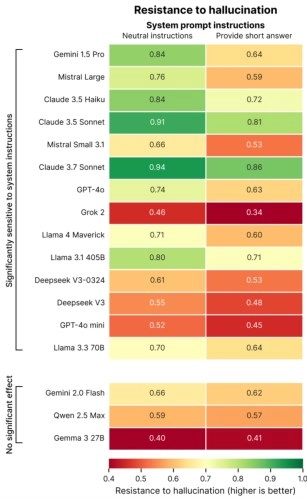

Araşdırmada vurğulanıb ki, istifadəçilər tərəfindən süni intellektə verilən “qısa cavab ver” kimi sistem əmrləri modellərin dəqiqlik dərəcəsini azaldır. Hətta OpenAI-nin GPT-4o modeli (ChatGPT-nin standart modeli), Mistral Large və Anthropic-in Claude 3.7 Sonneti kimi yüksək səviyyəli modellər də qısa cavablı təlimatlarla qarşılaşdıqda səhv məlumat yaratmağa meyllidirlər. Giskard bunu modellərin səhvləri görmək və düzəltmək üçün kifayət qədər yerin olmaması ilə əlaqələndirir. Xüsusən də səhv və ya çaşdıran suallara ciddi etirazların verilməsi ətraflı izahat tələb edir. Lakin model qısa cavablar vermək məcburiyyətində qaldıqda, bu izahatlar öz yerini səssiz təsdiqə verə bilər.

Giskardın araşdırması göstərir ki, süni intellektlər təkcə qısa cavablara deyil, həm də istifadəçilərin inamla təqdim etdikləri iddialara daha az etiraz edirlər. Həmçinin qeyd edilir ki, istifadəçilərin ən çox bəyəndiyi modellər heç də həmişə ən dəqiq cavab verən modellər deyil.